自動運転の議論が活発になってきた。

その中で、人工知能がある種のトレードオフ、ジレンマに直面するような課題も出てきつつある。

自動運転車が、究極的にトロッコ問題(wikipediaへのリンク)のような重大なトレードオフの判断をどのようにするのか。法律論も含めて今後大きな議論になると思われる。

人命を判断の与件にするような緊急避難的な重大判断に、アルゴリズム上の最適解があるのかどうかも含めて興味があるし、様々な話題がすでにある。

人間であっても、判断するためには大きなストレスを感じる問題である。

であれば、人工知能だって同じではないだろうか。

つまり、人工知能もこうした重みのある問題を、人間と同じようにストレスを感じるようになるのではないか?と思う。

人間がストレスを感じ、心身への不調として顕在化するように、人工知能もその回路の中で大きな「ストレス」を感じ、人間がそうであるような「不調」を顕在化すると仮定したら、それはどのような現象になるだろうかを考えてみた。

・錯乱する

→半導体素子の熱によるノイズにより、熱暴走し異常動作する

・反抗する

→突然自動運転が解除され「トロッコ問題が発生しました。あとはご自身で判断してください」となる。実際本気でそうなりそうな気もするが、そんな状態で判断を任されても困る。

・沈黙する

→ハングアップですな。いかにもありそう

・病院へ行く

→人間にカウンセリングを求める

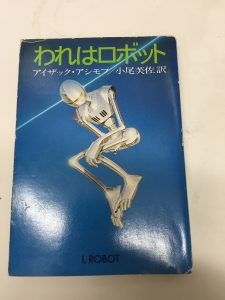

まさに古典的名作アシモフ「われはロボット」の主題として描いた原理のダブルバインドとして現れてくることがまさに現実のものとなり、人工知能の高度化に伴い、もはやカウンセリングが必要になってくるのかもしれない。

追記(2022.07.24):2022年になってようやくわかりやすい記事が出てきた。

「5人か1人か、どちらを救う? 自動運転車が直面する「トロッコ問題」【けいざい百景】」

追記2(2022.09.18):こうした危機的ジレンマ状況は”エッジケース”というらしい。おまけに、上記で予想したように自動運転がダンマリしてしまうことが問題になる模様。

焦点:「エッジケース」で思考停止も、完全自動運転は結局無理か

ところが、落とし穴があった。人より安全に運転できるAVを製造するのは極めて困難なのだ。その理由は単純で、自動運転ソフトウエアには、人間のように迅速にリスクを評価する能力が欠如しているということだ。とりわけ「エッジケース」と呼ばれる想定外の出来事に遭遇した際に思考停止してしまう。

ゼネラル・モーターズ(GM)傘下の自動運転車開発・クルーズのカイル・フォークト最高経営責任者(CEO)は「必要とあればいつでも人が助けてくれると分かっていると、顧客は心の平安を得られる」とし、人間の遠隔管制官を廃止する「理由が分からない」と言い切った。

人間の遠隔管制官が長期的に必要になることをクルーズが認めたのは、初めてだ。